Parece ser que se está cocinando una reforma del examen que hacen los alumnos en España antes de entrar en la universidad, que se llamó Selectividad originalmente, y que ha cambiado varias veces de nombre en los últimos años, al ritmo de las repetidas leyes educativas que hemos tenido. Desde el ministerio se dice que se quiere diseñar un «examen competencial», siguiendo la idea de lo que se hace en otros países europeos. Es muy posible que en otras áreas esto tenga bastante sentido, pero si hablamos de matemáticas y pensando en la interpretación mayoritaria en nuestro país de «competencia matemática», lo que está por venir me genera bastante preocupación. En todo caso, el objetivo de esta entrada es reunir ejemplos de exámenes análogos de diferentes países que he ido publicando en twitter en los pasados meses bajo la etiqueta #ReformaSelectividad. Esta es la lista, en el orden en el que fui recopilando los datos.

- Portugal: este es el enlace a su instituto de evaluación educativa, donde está toda la información. Los datos que me parecen más relevantes son que el examen dura 150 minutos (+ 30 mins de «tolerancia»), se incluye un formulario al principio y se permite el uso de calculadora gráfica. Es obligatorio contestar a cierto número de preguntas, señaladas en el enunciado, y además se eligen las mejores notas del resto de los ejercicios (los números precisos varían de unos exámenes a otros). Estos son los exámenes de 2022.

- Matemáticas A (después de 12 cursos)

- Matemáticas B (después de 11 cursos)

- Matemáticas Aplicadas a CCSS (después de 11 cursos)

- Italia: este es el enlace a la página del Ministerio de Educación con información general sobre la prueba. Aquí, un ejemplo del examen de matemáticas, y aquí una página con ejemplos de examen de los últimos 20 años. Se permiten calculadoras gráficas (sin cálculo simbólico). El examen consta de varias preguntas cortas y de dos problemas, de los que hay que resolver uno. La duración máxima del examen es de 6 horas, lo que da una idea de que se trata de auténticos problemas (parece que con bastante preponderancia del análisis).

Añadido el 12-06-2024: Italia tiene 13 cursos de escolaridad obligatoria, previos a la universidad. - Singapur: la información sobre el examen preuniversitario de Singapur se puede encontrar en esta entrada de este mismo blog. (Y buscando la etiqueta Singapur se llega a mucha más información sobre su enseñanza de las matemáticas).

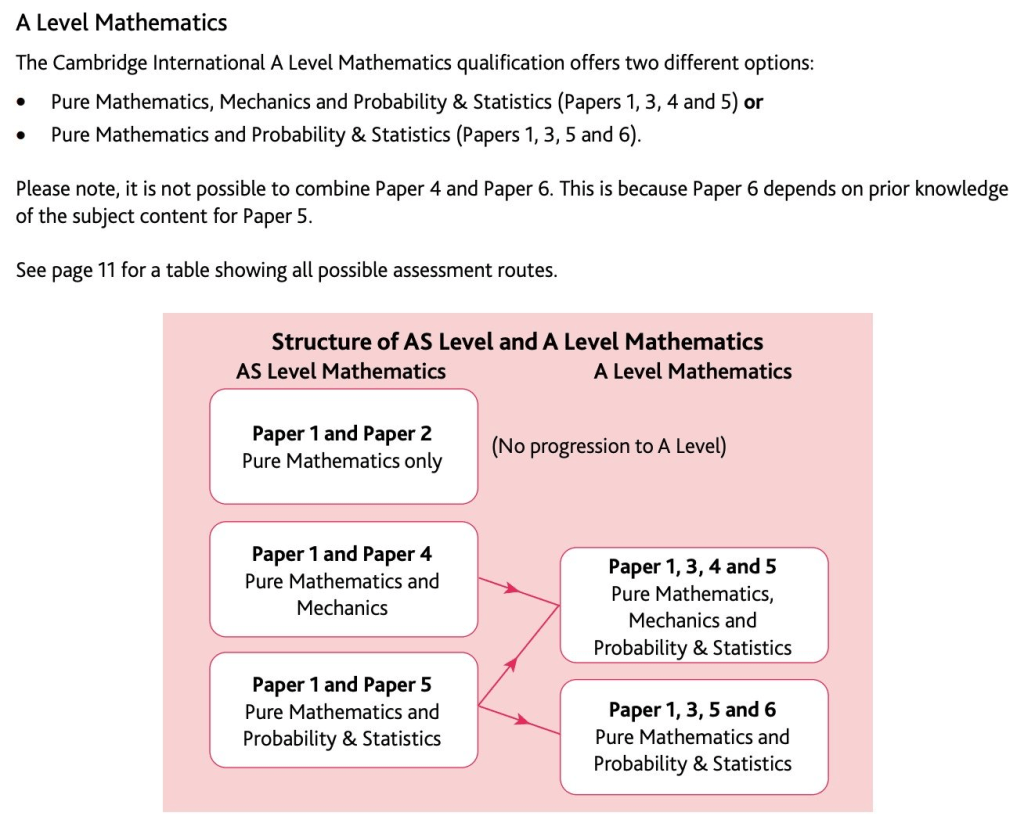

- Gran Bretaña: su «Bachillerato» consiste en preparar una serie de A-levels. Parece que el mínimo para seguir estudiando son 3, y hay estudiantes que llegan a 5. Hay dos niveles (la S de AS es de “subsidiary»). En la imagen vemos las dos especialidades, cada una con un total de 4 exámenes.

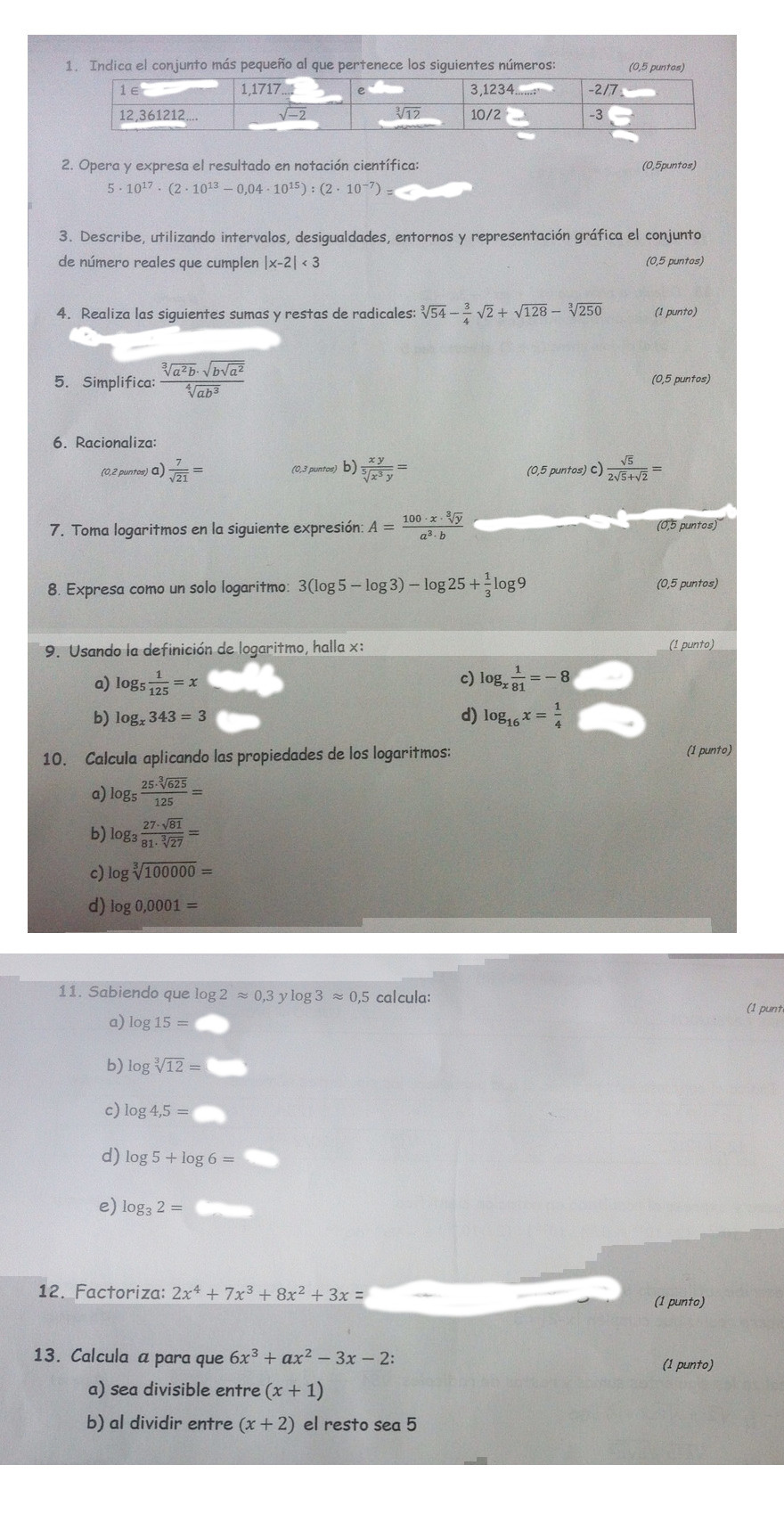

Aquí están los ejemplos de exámenes. Se permite lista de fórmulas y, sobre la calculadora, todos tienen el comentario “You should use a calculator where appropriate“ Nada de modelización, nada de contextos, excepto en Estadística y Probabilidad.

- https://www.cambridgeinternational.org/Images/415312-2020-specimen-paper-1.pdf (1 h 50 min), con lista de fórmulas, análisis, álgebra y geometría, con preguntas “clásicas”

- https://www.cambridgeinternational.org/Images/415314-2020-specimen-paper-2.pdf (1 h 15 min), misma idea que el anterior (corresponde al nivel “subsidiary”)

- https://www.cambridgeinternational.org/Images/415315-2020-specimen-paper-3.pdf (1 h 50 min), también “clásico”, como el 1. Llega a contenidos más avanzados. (Una ecuación diferencial).

- https://www.cambridgeinternational.org/Images/415317-2020-specimen-paper-4.pdf (1 h 15 min), Mecánica.

- https://www.cambridgeinternational.org/Images/415319-2020-specimen-paper-5.pdf (1 h 15 min), Probabilidad y Estadística.

- https://www.cambridgeinternational.org/Images/415320-2020-specimen-paper-6.pdf (1 h 15 min), Probabilidad y Estadística.

- Alemania (Baviera): el sistema educativo alemán está descentralizado, y cada Land tiene su propia Abitur. Aquí se puede acceder a los exámenes de matemáticas de Baviera, y con la ayuda de google aquí están las traducciones:

Los exámenes constan de dos partes, la primera de 70 minutos y la segunda de 200 minutos. Es llamativo que las dos versiones (con y sin CAS) son muy similares, y difieren solo en algún apartado de dos o tres problemas. En la tabla vemos la distribución de puntuaciones, y resulta llamativa la ausencia del álgebra.

| Parte 1 | Parte 2 | |

| Análisis | 20 | 40 |

| Estocástica | 5 | 25 |

| Geometría | 5 | 25 |

| Total | 30 | 90 |

Hay preguntas con modelos de situaciones realistas que me han parecido muy interesantes. Los modelos ya vienen dados, en la forma de «esta función modela esta situación». Lo que se pide en el examen es saber interpretar diferentes hechos matemáticos en el contexto de los modelos datos. Unas preguntas de probabilidad que me han gustado, y que no he visto en nuestro país, son del tipo de «busca un evento cuya probabilidad sea esta». Tampoco llegan a la inferencia estadística. Parece que opinan que mejor sentar bien las bases, y dejar la inferencia para más adelante.

- Francia: Está en proceso de cambio. Hasta ahora tenían tres bachilleratos (Científico, Económico y social, Literario) y la información de Wikipedia sobre el Baccalauréat francés y su evolución histórica se puede encontrar aquí.

En el nuevo sistema solo hay un bachillerato, con asignaturas comunes y asignaturas optativas. Wikipedia, de nuevo, tiene una completa descripción de esta organización aquí.

Las matemáticas no están entre las asignaturas comunes. En el examen final hay pruebas de Francés (uno oral, otro escrito), Filosofía, y un examen oral, parece que general. Se examinan de dos asignaturas de las específicas, que tienen bastante peso. Cada una son 16 puntos. Por comparación, Francés son 10 puntos en total, Filosofía 8. Parece que en la actualidad hay un fuerte debate porque hay menos alumnos estudiando matemáticas, en particular menos alumnas. Aquí, un ejemplo con algunos datos.

Este es el examen de Matemáticas del año 2021. Se permiten calculadoras, y habla de «en modo examen», lo que deja claro que se trata de calculadoras del siglo XXI. Tres grandes preguntas comunes (una de cálculo/análisis, una de geometría, una de probabilidad) y luego otra que hay que elegir entre dos (las dos de análisis).

Para los interesados, pdf y LaTeX del examen aquí.

Para los lectores que no conozcan el sistema español, en este enlace de la Universidad de Alcalá se puede acceder a los exámenes de EvAU (así se llama ahora este examen en la Comunidad de Madrid) de los últimos años. Los exámenes de las diferentes comunidades autónomas españolas pueden ser bastante diferentes, y este tema daría por sí solo para varias entradas.

Para terminar, una pequeña tabla resumen con la duración de las pruebas en diferentes países, todos los que he mencionado y algunos más de los que solo tengo información parcial.